Tesla, insiste en que el futuro de la compañía no es igualar a competidores como BYD en la fabricación de coches eléctricos, sino en autos que puedan conducirse completamente solos. Sin embargo, ¿Qué tan cierto y segura es la conducción autónoma? Se desató una locura con este tema, que hasta se llegó a estrellar un auto para comprobarlo.

Una prueba de locos: Estrellar un Tesla para comprobar si se puede engañar al piloto automático

La perspectiva de Tesla hacia la tecnología de conducción autónoma es bastante particular, ya que se enfoca solamente en cámaras e inteligencia artificial, sin usar sensores extras como radares o el sistema LIDAR. Musk confirmó que no tendrán esta función tan esperada, pero continúan con su camino a lo automático.

Los radares funcionan como rayos láser que capturan en 3D la información del entorno al auto. Pero, para Tesla no es necesario, y posiblemente es un gran error, o al menos eso fue lo que demostró un experimento realizado por un famoso youtuber.

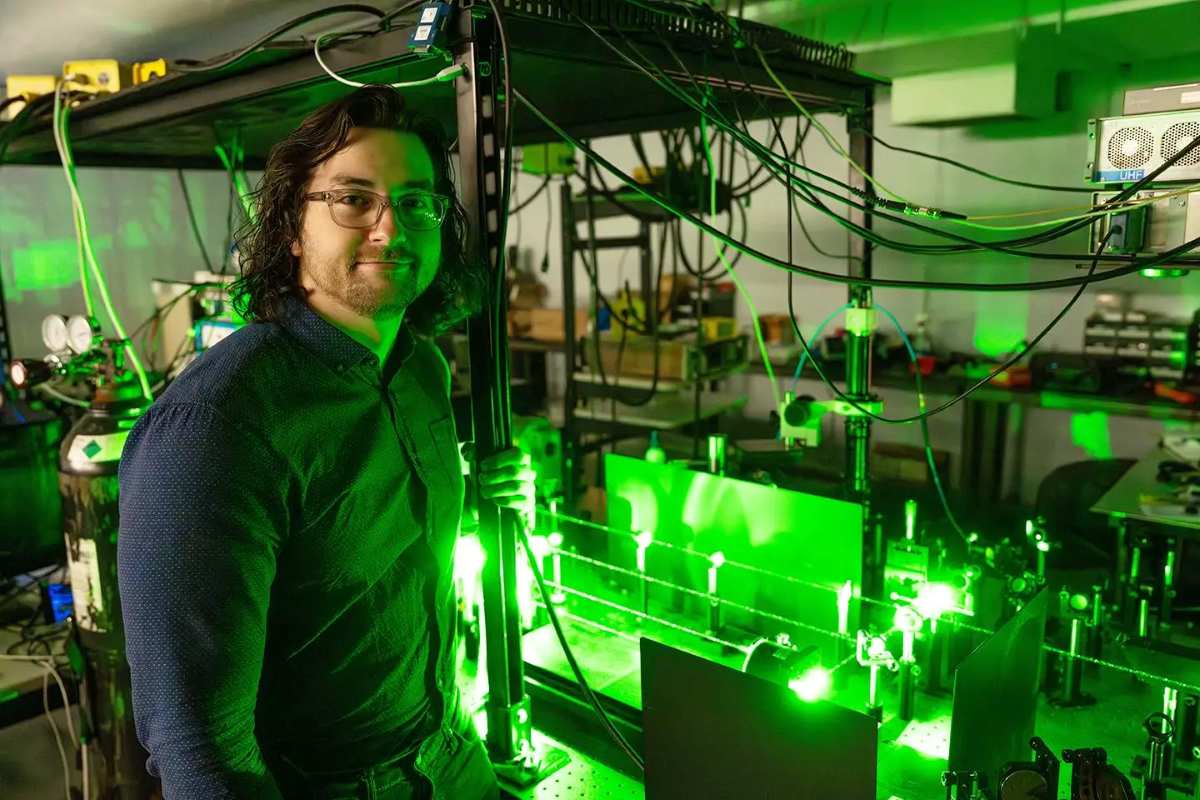

Un nuevo video del youtuber e ingeniero Mark Rober ilustra las debilidades de este enfoque. En su canal, el exingeniero de la NASA, describe una prueba inspirada en un antiguo corto de Looney Tunes: ¿puede una pared falsa pintada “engañar” a un Tesla en piloto automático para que se estrelle?

El polémico video desató un debate en torno a la tecnología de asistencia al conductor de Tesla, con fanáticos que protestaron y argumentaron que debería haber utilizado el software de conducción autónoma total (FSD) más sofisticado y costoso de la compañía.

¿Qué sucedió en el experimento? Estas son las conclusiones que llegaron

En la prueba se descubrió que un coche Tesla en piloto automático fue engañado por una pared falsa al estilo de la caricatura del Coyote, pintada para parecerse a la carretera que tenía delante, y el coche eléctrico de Tesla, la atravesó en lugar de parar como era de esperarse.

Las imágenes son bastante contundentes, con secuencias a cámara lenta que mostraban al coche no solo impactando contra la pared de poliestireno, sino también contra un maniquí de un niño. El Tesla también fue engañado con lluvia y niebla simuladas.

El truco quería demostrar las deficiencias de confiar completamente en las cámaras, en lugar de los sistemas LIDAR y de radar que utilizan otras marcas y fabricantes. ¿Es esto realmente una prueba irrefutable o el piloto automático se desactivó por sí solo mientras estaba bajo control humano?

Esto pone en duda sobre si, el piloto automático es seguro, ya que hay documentos que afirman, se suele desactivar, justo antes de un choque. Los reguladores han descubierto previamente que el software avanzado de asistencia al conductor se desactiva una fracción de segundo antes del impacto.

Es un enfoque que ha dado a inquietudes sobre el intento de Tesla de evadir la culpa, desactivando automáticamente cualquier función de asistencia al conductor, posiblemente incriminatoria antes de un accidente. Se especula que, con ayuda de Trump ocultan accidentes, pero no hay nada confirmado.

¿Será que el futuro de los pilotos automáticos no prosperará?

Muchos desconfían de estas tecnologías y temen por su integridad. De hecho, en varios países le prohibieron a Tesla este tipo de conducción. Pero, es la innovación y aunque, los sistemas de piloto automático y conducción autónoma de Tesla han mejorado con los años, siguen vinculados a accidentes.

Muchos expertos en autonomía con amplia experiencia afirman que el enfoque de Tesla basado en cámaras, que Musk promociona por su similitud con la conducción humana, siempre será insuficiente si el objetivo es crear vehículos autónomos más seguros y eficaces que los humanos.

Es poco probable que te estrelles accidentalmente contra una pared falsa, ya que no eres un personaje de dibujos animados. Pero este video te hace preguntarte qué más podría pasar desapercibido el sistema de cámara de Tesla si los coches del futuro ni siquiera vienen con volante ni pedales.

Deja una respuesta